|

국내 최대 검색 회사인 네이버가 초거대언어모델(LLM· Large Language Model) 인공지능(AI)인 ‘하이퍼클로바X’를 24일 공개했다. 챗GPT가 돌풍을 일으킨지 9개월 만이다. 네이버는 초거대AI 개발을 위해 지난 5년 동안 1조 원 넘게 투자했고, 서버 60만대를 갖춘 데이터센터 ‘각 세종’도 연내 오픈한다.

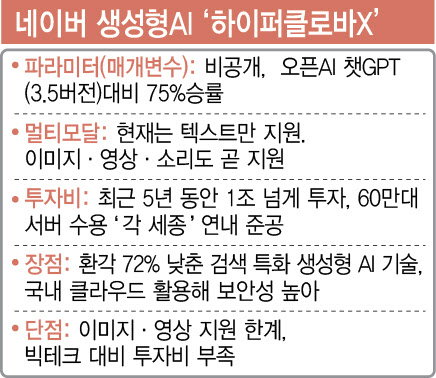

네이버 초거대 AI의 품질을 결정하는 건 파운데이션 모델 ‘하이퍼클로바X다’. 네이버는 2021년 11월 오픈AI·화웨이에 이어 세계에서 세번 째로 자체 LLM을 공개했는데, 당시 파라미터(매개변수)는 2040억개였다. 이번엔 매개변수를 공개하지 않았다.

최수연 네이버 대표는 “지난 번에는 R&D차원의 목적이 커서 공유했지만, 이번엔 안하기로 했다. 저희 언어모델의 핵심 노하우이기 때문”이라고 말했다. 같은 맥락에서 오픈AI 역시 4.0모델부터는 파라미터를 공개하지 않고 있다. 파라미터 비공개는 LLM모델의 경량화 추세와도 관련있다. 글로벌 빅테크들조차 LLM 개발에 10빌리언 달러(13.2조 원)가 든다고 할 정도여서 그렇다.

|

네이버는 KT, LG 등과 함께 국내에서 거의 유일하게 파운데이션 모델을 개발하는 회사다. 많은 국내 IT기업들이 챗GPT 연동에 집중하거나, 여러 개의 파운데이션 모델을 섞어 쓰는 멀티 엔진에 집중하나, 네이버는 한국어 데이터를 활용해 꿋꿋하게 자체 LLM 생태계를 만들고 있다.

생성형AI 검색 ‘큐:(CUE:)’를 만든 네이버 서치 US 김용범 AI 기술총괄은 “MS 빙과 달리, 9월 출시될 ‘큐:’는 학습데이터에 의존하는 게 아니라 질의 이해(Reasoning)라는 독자 기술로 AI가 질문이 왔을 때 사람처럼 판단하고 검색한다”면서 “여기에 답변이 포함된 출처 수집(Evidence Selector), 답변과 출처의 사실성 일치 확인(Factually Consistent Generation) 등을 거쳐 환각(Hallucination)이 72% 줄어든다”고 자신했다.

최수연 네이버 대표는 “매일매일 갱신되는 최신 데이터들이 학습된 대규모 언어모델이라는 점, 자연스러운 한국어 표현, 한국 사회의 맥락, 법과 제도 같은 것들을 모두 이해한다는 점이 가장 차별점이라고 생각한다”고 말했다. 성낙호 총괄은 “내부적으로 테스트해보니 GPT-3기준으로 ‘하이퍼클로바X’가 75%정도 (정확성 등에서)승률이 있었다”면서 “기업 입장에선 외국 모델은 보안에 불안할 수 있지만, 우리는 자체 클라우드에서 서비스하고 엔지니어링 자원도 풍부해 생성형AI를 도입하려는 기업을 더 잘 지원할 수 있다”고 언급했다.

![[포토]명동성당 성탄 대축일 미사](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122500276t.jpg)

![[포토]크리스마스엔 스케이트](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122500245t.jpg)

![[포토]37번째 거리 성탄예배 열려 방한복·도시락으로 사랑 나눔](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122500231t.jpg)

![[포토]조국혁신당 공수처 앞에서 기자회견](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122500219t.jpg)

![[포토]우리 이웃을 위한 크리스마스 선물](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122500173t.jpg)

![[포토]메리크리스마스](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122400797t.jpg)

![[포토]즐거운 눈썰매](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122400779t.jpg)

![[포토]취약계층 금융 부담 완화, '인사말하는 이재연 원장'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122400633t.jpg)

![[포토]국민의힘 의원총회, '모두발언하는 권성동 원내대표'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122400506t.jpg)

![[포토]윤석열 대통령 탄핵심판 첫 변론 준비기일 27일 예정대로 진행](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/12/PS24122400433t.jpg)